Dlaczego Google i Microsoft tak histerycznie domagają się regulacji AI? By zniszczyć konkurencję

OpenAI, Microsoft i Google próbują zając pozycję oligopolistów. Wystarczy tylko przekonać wszystkich, że większe znaczy lepsze. I tu pojawił się problem. Otóż modele mniejsze – wymagające znacznie mniej danych treningowych oraz zasobów mocy obliczeniowej – mogą być wystarczająco skuteczne, lub nawet skuteczniejsze

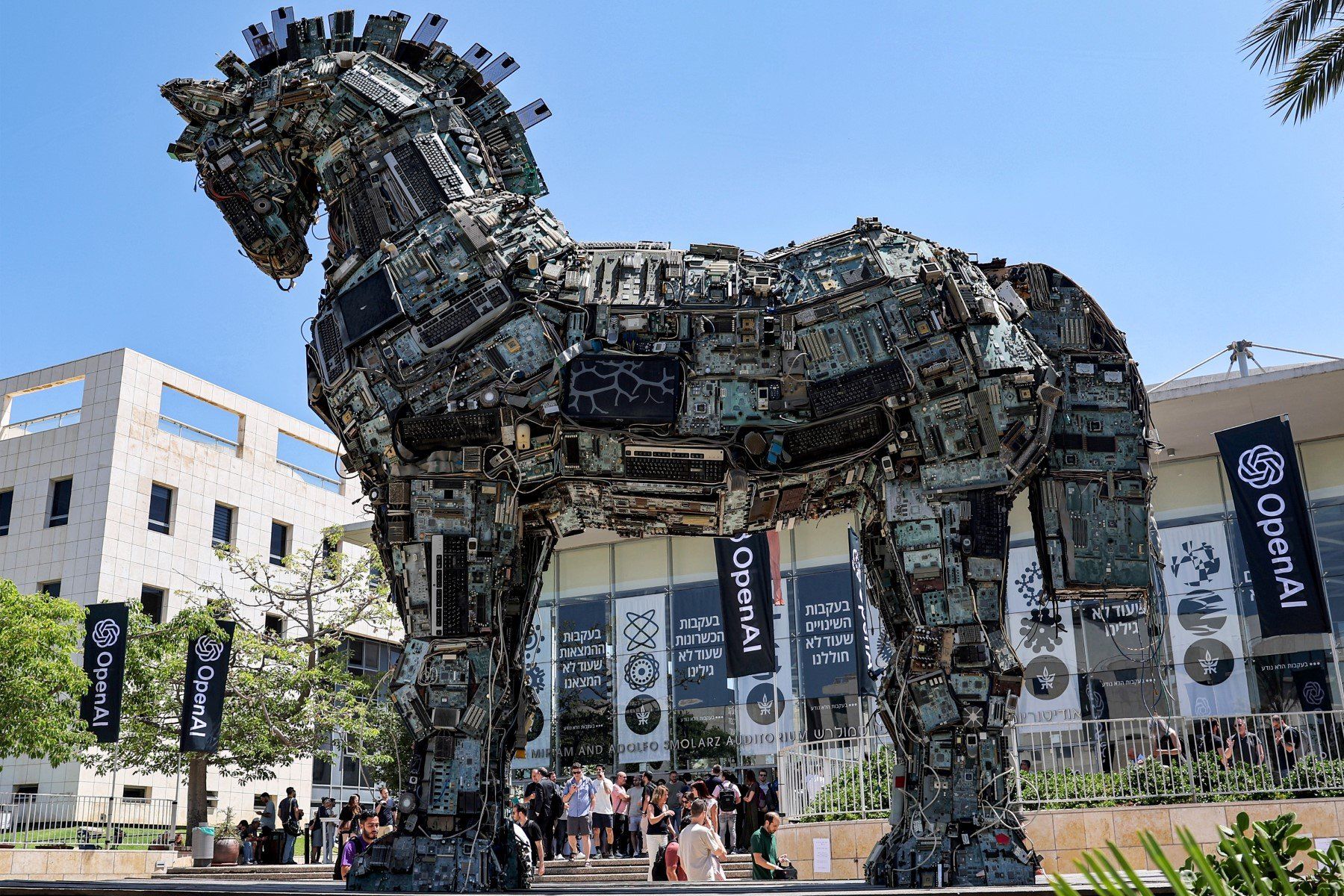

W połowie maja Sam Altman (szef OpenAI, firmy rozwijającej m.in. ChatGPT) przekonywał komisję Senatu Stanów Zjednoczonych, że „sztuczna inteligencja” jest potencjalnie niebezpieczna i wymaga silnych regulacji. W tym samym czasie firma po cichu lobbowała unijnych prawodawców, by tworzone przez nią modele uczenia maszynowego nie były uwzględnione w kategorii wysokiego ryzyka w projekcie unijnego rozporządzenia dotyczącego „sztucznej inteligencji”.

Już tydzień po zeznaniach w amerykańskim Senacie, tenże sam szef OpenAI przekonywał na Uniwersytecie Warszawskim, że „oddanie ChatGPT4 na wczesnym etapie w ręce społeczeństwa ma sens, bo pomaga zauważyć błędy, zanim urosną w siłę i staną się niebezpieczne.”

A niecały tydzień później podpisał oświadczenie straszące „zagładą spowodowaną AI” i porównujące zagrożenia związane z tymi narzędziami do pandemii i wojny jądrowej (notabene znaczące, że katastrofa klimatyczna nie jest tam wymieniona).

Cykl „SOBOTA PRAWDĘ CI POWIE” to propozycja OKO.press na pierwszy dzień weekendu. Znajdziecie tu fact-checkingi (z OKO-wym fałszometrem) zarówno z polityki polskiej, jak i ze świata, bo nie tylko u nas politycy i polityczki kłamią, kręcą, konfabulują. Cofniemy się też w przeszłość, bo kłamstwo towarzyszyło całym dziejom. Rozbrajamy mity i popularne złudzenia krążące po sieci i ludzkich umysłach. I piszemy o błędach poznawczych, które sprawiają, że jesteśmy bezbronni wobec kłamstw. Tylko czy naprawdę jesteśmy? Nad tym też się zastanowimy.

Jak nie wiadomo, o co chodzi, to chodzi o pieniądze

To wszystko może się wydawać dziwne, dopóki nie uświadomimy sobie, że szef OpenAI nie jest jakimś filozofującym technologicznym geniuszem. Jest po prostu sprzedawcą. Kolejnym „Januszem tech-biznesu”, który próbuje wycisnąć jak najwięcej zysku w sytuacji, w której opinia publiczna jest chwilowo omamiona świecidełkami — osoby pracujące dla OpenAI opublikowały wręcz pracę nieironicznie zatytułowaną „Przebłyski Ogólnej Sztucznej Inteligencji”! — a pieniądze inwestorów płyną szerokim strumieniem.

Obecnie zadanie Altmana polega więc z jednej strony na tym, by podtrzymywać fascynację publiki (a więc i inwestorów!) ogólnie tematyką modeli uczenia maszynowego, a w szczególności tworzonymi przez OpenAI na ich bazie narzędziami. Z drugiej strony, by wyciąć potencjalną konkurencję.

OpenAI i inne molochy technologiczne — Google oraz współpracujący z OpenAI Microsoft — skupiły się na ogromnych modelach językowych („LLM”, od ang. „Large Language Model”), które trenowane są w oparciu o gigantyczne ilości danych przy użyciu niewyobrażalnych wręcz zasobów mocy obliczeniowej. Z ich perspektywy ma to sens: niewiele innych firm ma dostęp do odpowiednio potężnej infrastruktury, by móc tu realnie konkurować. Google i Microsoft mają też dane, zescrape'owane (innymi słowy, pobrane; od ang. „scrape” — „skrobać”) z Internetu na potrzeby swoich wyszukiwarek internetowych. Znów: mało kto taki zasób danych ma na podorędziu.

Konkurencji trudno będzie nadgonić! A klienci, nie będąc w stanie odpalić tak ogromnych modeli na własnej infrastrukturze, zostaną przywiązani do konkretnego usługodawcy. OpenAI, Microsoft i Google próbują więc zając pozycję oligopolistów. Wystarczy tylko przekonać wszystkich, że większe znaczy lepsze. Proste?

Przeczytaj także:

Większe nie znaczy lepsze

I tu pojawił się problem. Otóż okazuje się, że modele mniejsze — a więc wymagające znacznie mniej danych treningowych oraz zasobów mocy obliczeniowej — mogą być wystarczająco skuteczne, lub nawet skuteczniejsze w konkretnych zastosowaniach, niż LLMy Big Techów.

Ze względu na mniejszy rozmiar łatwiejsze jest poprawne opisanie i skatalogowanie danych treningowych, łatwiej zatem uniknąć kodowania uprzedzeń w trenowanym modelu. Mniejsze zasoby obliczeniowe wymagane przy ich trenowaniu oznaczają zaś, że jeśli w raz wytrenowanym modelu zostaną znalezione poważne błędy, model można po prostu wytrenować jeszcze raz na lepiej opracowanych danych.

Pisały o tym lata temu autorki fundamentalnej pracy naukowej dotyczącej (prawdziwych, nie wydumanych) zagrożeń związanych z wielkimi modelami językowymi. Jedną z ich rekomendacji było skupienie się właśnie na modelach mniejszych. Po publikacji pracy te z nich, które pracowały wówczas w Google, zostały albo zwolnione, albo zmuszone do odejścia.

Czas zweryfikował tę rekomendację. Niedawno do Internetu wyciekł wewnętrzny dokument giganta, którego autor lub autorka zauważa, że to właśnie mniejsze modele językowe, rozwijane w ramach ruchu otwartego oprogramowania, stanowią najpoważniejsze zagrożenie dla ogromnych modeli Google'a, OpenAI czy Microsoftu. „Modele rozwijane w ramach ruchu otwartego oprogramowania są szybsze, łatwiejsze do dostosowania do własnych potrzeb, bardziej prywatne, i ogólnie sprawniejsze” — czytamy w dokumencie.

Otwarta kooperacja kontra silosy Big Techów

Otwarte oprogramowanie tworzone jest często przez fascynatów (choć jest też wiele firm, które je rozwija), a podstawową zasadą tej społeczności jest dzielenie się oprogramowaniem i jego kodem źródłowym — tak, by każda osoba, która ma odpowiednie umiejętności, mogła je ulepszać i dostosowywać do swoich potrzeb. Ta chęć dzielenia się wiedzą i narzędziami jest dokładną odwrotnością zasad panujących w OpenAI (choć „open” znaczy „otwarty”, firma przestała otwarcie dzielić się swoimi rezultatami badawczymi), Microsofcie czy Google.

I właśnie między innymi otwartość oraz znacznie mniejsza wielkość modeli, jak zauważa autorka lub autor wewnętrznego dokumentu Google, są powodem, dla którego otwartoźródłowe modele są takim zagrożeniem dla LLMów technologicznych molochów. Pozwalają one znacznie szybciej testować, ulepszać, i rozwijać modele otwarte.

Modele uczenia maszynowego to rodzaj oprogramowania. Mniejsze modele oznaczają mniejsze wymagania techniczne, a zatem możliwość ich trenowania i uruchomienia bezpośrednio przez osoby z nich korzystające na ich własnych urządzeniach, poza kontrolą technologicznych molochów. „Bariera wejścia związana z trenowaniem i eksperymentowaniem obniżyła się z poziomu pełnego zaangażowania poważnej organizacji badawczo-rozwojowej, do poziomu jednej osoby, wieczora, i mocnego laptopa” — czytamy w wyciekłym dokumencie. Jeden z małych otwartoźródłowych modeli językowych udało się testowo uruchomić na smartfonie, bez konieczności wysyłania zapytań poza urządzenie!

„Wiele nowych pomysłów wychodzi od zwykłych ludzi”

To obniżenie bariery wejścia w praktyce oznacza, że więcej osób może realnie rozwijać modele językowe i tworzyć narzędzia na nich oparte. Znów cytując dokument: „wiele nowych pomysłów wychodzi od zwykłych ludzi”. W tym narzędzia, które albo Big Techom by do głowy nie przyszły, albo które trudno „monetyzować”, więc czemu miały by one je rozwijać?

Narzędzia te będą potencjalnie mogły być działać bezpośrednio na naszych urządzeniach, zamiast wymagać ogromnej infrastruktury Big Techów. Z jednej strony daje to nam więcej nad nimi kontroli; z drugiej, uniemożliwia zbieranie o nas danych firmom technologicznym zza oceanu.

Narzędzia oparte o uczenie maszynowe, z których już dziś możemy korzystać na naszych urządzeniach bez wysyłania danych do Wielkiego Brata, istnieją od lat. Choćby rozpoznawanie tekstu na zdjęciach, dostępne zarówno na urządzeniach z Androidem, jak i tych od firmy Apple.

Przykładami zastosowania modeli uczenia maszynowego tworzonych w ramach ruchu otwartego oprogramowania są choćby: możliwość automatycznego wymazywania twarzy na zdjęciach wysyłanych za pomocą komunikatora Signal (bardzo ważne dla aktywistów i na protestach); rozpoznawanie twarzy w kolekcjach zdjęć zarządzanych za pomocą pakietu digiKam; automatyczne tłumaczenie tekstu pomiędzy różnymi językami, działające bezpośrednio w przeglądarce Firefox. Powstał też projekt smart-głośnika, przyjmującego komendy głosowe, ale szanującego prywatność. Nie może też zabraknąć chatbota podobnego do ChatGPT, ale działającego bezpośrednio na naszym laptopie.

Przykłady — w różnym stadium rozwoju, od prototypów po gotowe rozwiązania — można oczywiście mnożyć. A wszystko to bez wysyłania tekstu na żadne serwery, bez umożliwiania zbierania o nas danych i bez przywiązania nas do jednego dostawcy.

Narzędzia wyspecjalizowane

Otwartoźródłowy projekt Tesseract, również oparty o model uczenia maszynowego, pozwala wbudować rozpoznawanie tekstu do specjalistycznych narzędzi. Używany jest na przykład w oprogramowaniu Aleph, z którego korzystają organizacje zajmujące się dziennikarstwem śledczym (na przykład znane z Panama Papers OCCRP).

Organizacje te mogą uruchomić Aleph (z wbudowanym rozpoznawaniem tekstu) we własnej infrastrukturze. To niezwykle ważne! Dziennikarze i dziennikarki śledcze pracują często z niezwykle wrażliwymi dokumentami. W wypadku wielu z nich udostępnianie ich jakiejś zewnętrznej firmie w celu odczytania tekstu byłoby po prostu niedopuszczalne. Nie mówiąc już o tym, że te dokumenty mogą przecież dotyczyć śledztwa dziennikarskiego skupiającego się na tych właśnie firmach!

Doskonale to ilustruje możliwości wykorzystania mniejszych modeli uczenia maszynowego w sytuacjach, w których skorzystanie z rozwiązań gigantów byłoby bardzo problematyczne lub wręcz niemożliwe.

Przebłyski prawnie gwarantowanego oligopolu

OpenAI, Google i Microsoft zapędziły się w pewnym sensie w kozi róg. Próbując — poprzez promowanie i poleganie na gigantycznych modelach językowych — za jednym zamachem wyciąć konkurencję, a jednocześnie przywiązać osoby i firmy korzystające z tych narzędzi do siebie, nie doceniły tego, jak skuteczne i użyteczne mogą być modele znacznie mniejsze.

Starają się teraz tak sterować debatą publiczną i pracami nad regulacjami w obszarze „sztucznej inteligencji”, by uniemożliwić lub przynajmniej utrudnić tworzenie rozwiązań mniejszych, zwłaszcza tworzonych w modelu otwartego oprogramowania. Stąd straszenie „zagładą spowodowaną przez AI”, i publiczne domaganie się regulacji. Działy prawne wielkich korporacji z biurokracją i formularzami sobie poradzą, niezależni developerzy i niezależne projekty pod lawiną papieru utoną.

Ta strategia jest jednak niebezpieczna o tyle, że dobre regulacje, skupiające się na faktycznych zagrożeniach (a nie bzdurnych wizjach zagłady z filmów science-fiction), musiałyby dotyczyć między innymi dokładnego, dogłębnego opisu danych treningowych. Z takim wymogiem mniejsze modele poradzą sobie znacznie łatwiej, niż big-techowe LLMy, wytrenowane na danych zassanych z całego publicznego Internetu i słabo opisanych. Stąd więc ciche lobbowanie za tym, by produkty wielkich korporacji usunąć z katalogu „wysokiego ryzyka” w projektowanym unijnym rozporządzeniu.

Komu służy model

„Myślę, że większość obaw związanych z AI można rozumieć jako obawy związane z kapitalizmem” — mówił dwa lata temu w wywiadzie pisarz science fiction Ted Chiang; autor m.in. opowiadania, na którym oparty był film „Nowy początek”.

Trudno się z tym nie zgodzić. W pogoni za zyskiem i pieniędzmi inwestorów, kapitaliści nadzoru lekce sobie ważą realne zagrożenia związane z ogromnymi modelami językowymi i realne krzywdy już dziś przez nie wyrządzane. Celowo próbują odwracać naszą uwagę, strasząc „sztuczną super-inteligencją”. Głośno domagają się regulacji, które po cichu starają się kształtować tak, by mogły im służyć za tarczę przeciwko konkurencji ze strony modeli mniejszych, niezależnie rozwijanych, mniej szkodliwych i mniej niebezpiecznych, otwierających kompletnie nowe pola wyspecjalizowanych zastosowań.

Modele językowe i ogólnie modele uczenia maszynowego to fascynująca, niezwykle obiecująca technologia. Aby jednak osiągnęła swój pełny potencjał, nie może zostać przejęta i zamknięta w grodzonych ogródkach kilku gigantycznych firm technologicznych.

Specjalista ds. bezpieczeństwa informacji, administrator sieci i aktywista w zakresie praw cyfrowych. Studiował filozofię, był członkiem Rady ds. Cyfryzacji, jest współzałożycielem warszawskiego Hackerspace’a. Pracował jako Dyrektor ds. Bezpieczeństwa Informacji w OCCRP – The Organised Crime and Corruption Reporting Project, konsorcjum ośrodków śledczych, mediów i dziennikarzy działających w Europie Wschodniej, na Kaukazie, w Azji Środkowej i Ameryce Środkowej. Współpracuje z szeregiem organizacji pozarządowych zajmujących się prawami cyfrowymi w kraju i za granicą. Współautor „Net Neutrality Compendium” oraz “Katalogu Kompetencji Medialnych”.

Specjalista ds. bezpieczeństwa informacji, administrator sieci i aktywista w zakresie praw cyfrowych. Studiował filozofię, był członkiem Rady ds. Cyfryzacji, jest współzałożycielem warszawskiego Hackerspace’a. Pracował jako Dyrektor ds. Bezpieczeństwa Informacji w OCCRP – The Organised Crime and Corruption Reporting Project, konsorcjum ośrodków śledczych, mediów i dziennikarzy działających w Europie Wschodniej, na Kaukazie, w Azji Środkowej i Ameryce Środkowej. Współpracuje z szeregiem organizacji pozarządowych zajmujących się prawami cyfrowymi w kraju i za granicą. Współautor „Net Neutrality Compendium” oraz “Katalogu Kompetencji Medialnych”.

Komentarze