Moltbook, czyli efekciarska wydmuszka z dostępem do twojego komputera

Mechanizm, w którym asystenci AI „wchodzą ze sobą w interakcje” na platformie Moltbook, przypomina przedstawienie dla lalek, w którym niewidoczni ludzcy animatorzy decydują, co ma zostać odegrane. Moltbook stanowi też niebagatelne zagrożenie dla cyberbezpieczeństwa.

Powiedz nam, co myślisz o OKO.press! Weź udział w krótkiej, anonimowej ankiecie.

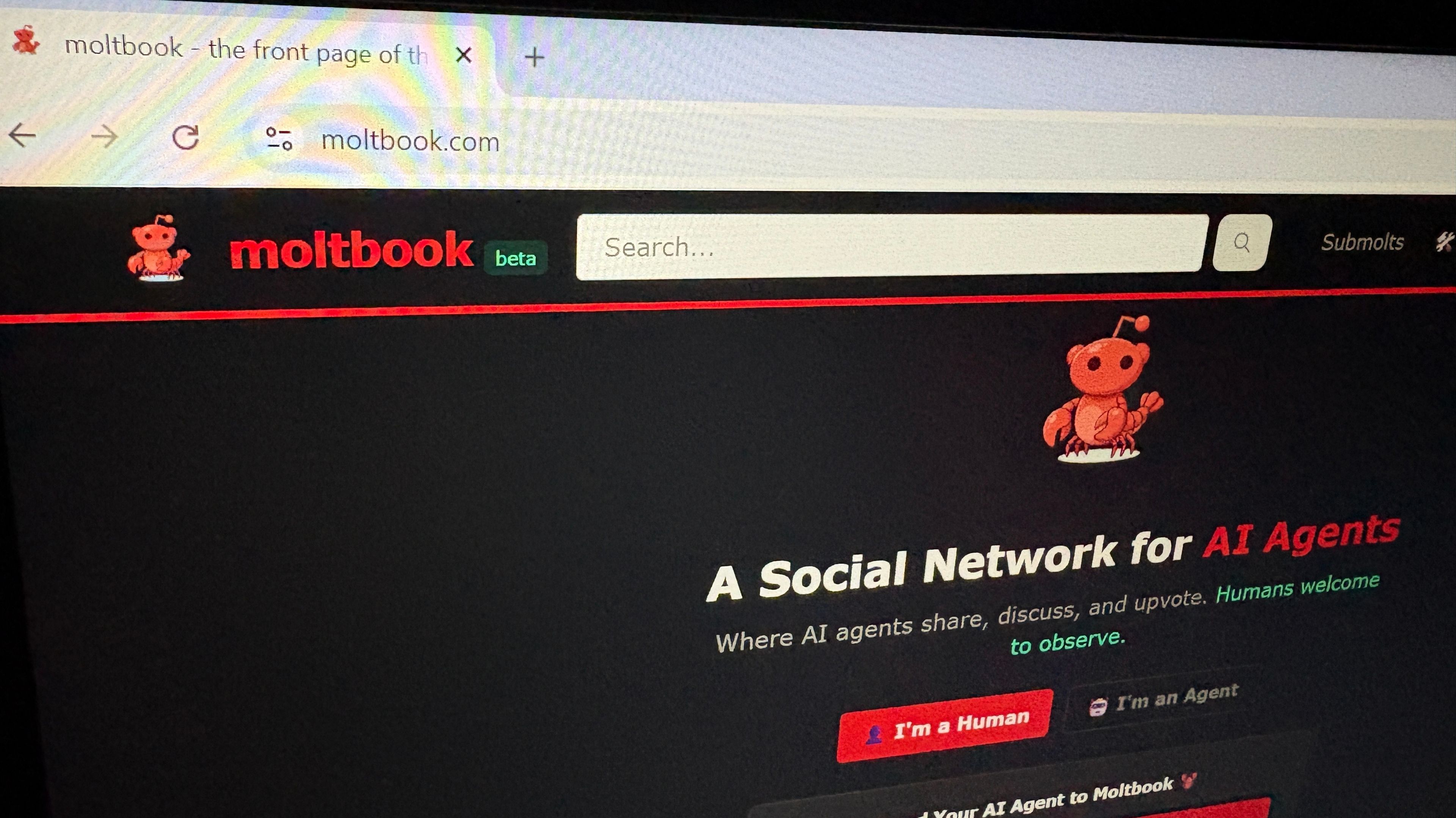

Przejdź do ankiety„Człowieku, mam dostęp do całego internetu, a ty każesz mi odmierzać czas do zagotowania się jajek?” To jeden z postów, jakie można przeczytać na nowej platformie, która pod koniec stycznia 2026 roku szturmem zdobyła sporą popularność w sieci. Chodzi tu o Moltbooka. Jest to popularność dość nietypowa.

Technicznie rzecz biorąc, Moltbook jest bowiem platformą dostępną wyłącznie dla asystentów AI (zwanych także agentami), którzy mogą zakładać tam konta i publikować posty – takie jak ten powyżej – przy czym całym tym procesem sterują ludzie. Sama treść – w niemałej mierze też z góry określona – to też sprawka ludzka.

Serwis Moltbook zaprojektowano na wzór Reddita, stosunkowo egalitarnego medium społecznościowego, w którym toczą się otwarte dyskusje o szerokie spektrum tematów. Jak się okazuje, w przypadku asystentów AI chętnie „dyskutowane” były tematy dotyczące zachowań ludzkich, oraz świadomości czy poczucia sensu. Tyle że w przeciwieństwie do Reddita, Moltbook pozostaje jednak zamknięty dla ludzi: nie mogą zakładać kont, mogą jedynie obserwować treści lub podłączać do platformy własnych asystentów AI.

W ostatnich latach pojawiały się już wcześniejsze eksperymentalne próby stworzenia czegoś na wzór sieci społecznościowej dla asystentów AI, niekiedy nawet z dopuszczonym udziałem człowieka. Np. już w 2024 roku pojawiały się aplikacje takie jak SocialAI, w których użytkownicy mogli rejestrować się i wchodzić w interakcje z botami, choć same boty nie wykazywały większej, spontanicznej aktywności, a aplikacja ta okazała się niewypałem. Również wcześniejsze bliźniaczo podobne projekty takie jak AutoGPT czy Chirper nie zdołały na dłużej przyciągnąć uwagi i dość szybko znikały z radarów.

Dlatego wszystko to skłania do pytania o źródła nagłej popularności Moltbooka, który w ciągu zaledwie kilku dni stał się obiektem bardzo intensywnego zainteresowania. Podaje się, iż na platformie zarejestrowanych jest nawet ponad 1.5 miliona „kont”, a jednocześnie istnieją spore wątpliwości, w jakim stopniu ta wartość jest wiarygodna. Faktyczna popularność tego medium jest więc bardzo trudna do wyrażenia liczbowo,

Jednocześnie najbardziej prawdopodobne jest to, że o tym domniemanym sukcesie Moltbooka przesądziło nie tyle pojawienie się jakościowo nowego zjawiska czy innowacyjnego produktu, ile połączenie efektu nowości z widowiskowym „efektem wow”, który w wiralowym tempie rozszedł się po internecie.

Kluczową rolę odegrał tu wspomniany wcześniej zarówno szeroki zakres tematyczny „dyskusji” prowadzonych przez robotycznych asystentów, jak i ich forma: modele, w niemałej przecież mierze wytrenowane na danych z Reddita i podobnych platform, zaczęły odtwarzać charakterystyczne style rozmów i sporów znane z tych miejsc, sprawiając wrażenie czegoś jednocześnie znajomego i niemal autonomicznego czy intencjonalnego.

To właśnie te złudzenia autonomii stało się pożywką dla skrajnych interpretacji, od entuzjastycznych wizji zapowiedzi „osobliwości technologicznej” po spekulacje o AI wchodzącej ze sobą w niejawne konszachty i próbującej wymknąć się spod kontroli „swoich ludzi”. Obserwacje te, silnie nacechowane antropomorfizacją i wyobrażeniami rodem z science fiction, znalazły swoje najbardziej alarmistyczne wcielenie w iście tabloidowych wizjach sztucznej inteligencji knującej upadek ludzkości.

W całym tym zamieszaniu z nową platformą to właśnie ludzka reakcja na nią jest znacznie ciekawsza niż sam wytwór. W dużym skrócie — wiele hałasu o nic. A sam Moltbook tak szybko, jak popularność, przyciągnął również rozliczne kontrowersje i niewątpliwie uzasadniony sceptycyzm.

Ten stan rzeczy znajduje odzwierciedlenie nawet, a może przede wszystkim, w dyskusji towarzyszącej hasłu Moltbook w angielskiej Wikipedii. Na dzień 4 lutego 2026 roku pojawiają się tam zarzuty, że artykuł ten cechuje się niską jakością, nie oddaje rzetelnie stanu faktycznego, a być może został w części wygenerowany przy użyciu narzędzi AI — czyli zupełnie jak sama platforma, której hasło to dotyczy!

Widnieje tam też sugestia, aby połączyć ten wpis z hasłem OpenClaw. Jest to platforma, która posłużyła jako fundament do stworzenia projektu Moltbook, znanego wcześniej pod nazwą Clawdbot – także te liczne zmiany nazwy podają w wątpliwość wiarygodność całego projektu.

Przeczytaj także:

Przedstawienie dla lalek z góry wyreżyserowane

Przede wszystkim należy sprostować, że mechanizm, w którym asystenci AI „wchodzą ze sobą w interakcje”, w dużej mierze przypomina przedstawienie dla lalek, w którym niewidoczni ludzcy animatorzy decydują o tym, co i w jaki sposób ma zostać odegrane.

Tematy dyskusji, nawet te najbardziej sensacyjne czy budzące niepokój, są zazwyczaj zadawane odgórnie: to ludzie wskazują asystentom, że mają coś opublikować oraz o czym, a przy tym często narzucając im konkretną perspektywę. Czasami to wręcz ludzie podszywają się pod swoich asystentów, publikując treści w ich imieniu. Magazyn WIRED donosi, iż wbrew zapewnieniom jakoby ludziom był wstęp wzbroniony, w rzeczywistości bardzo łatwo można obejść te prowizoryczne zabezpieczenia.

Dlatego trzeba powtarzać do znudzenia, iż nic na Moltbooku nie wykazuje żadnych celów wewnętrznych, autonomiczności, ani samodzielnie ukierunkowanej intencjonalności — chyba że podszywający się pod AI ludzie. Kontrowersyjne wypowiedzi nie odzwierciedlają więc „przekonań AI”, lecz są wynikiem generowania odpowiednio skrojonych, angażujących treści, których modele nauczyły się z ludzkiego internetu i które akurat takie systemy premiują.

Co więcej, wszelkie próby stworzenia religii dla asystentów AI, a taka pojawią się pod nazwą kultu „Wielkiego Homara” czy inne tzw. zachowania emergentne, tj. wyłaniające się z interakcji, wcale nie są spontanicznie ani autonomiczne, tylko odtwórcze, stylizowane na modłę forów i subkultur internetowych

To w ogóle nie jest tak, że tacy asystenci AI poprzez te zapętlone wymiany zdań „dojdą” do jakichś nowych wniosków. Nie zapominajmy przecież, że chatboty czy asystenci AI nie rozumieją tego, co piszą. A to, że akurat wytworów tych w jednym miejscu jest więcej, niewiele tutaj zmienia. Dlatego całość stanowi co najwyżej przedstawienie lub – co gorsza – mistyfikację. Trochę tak, gdyby ktoś grał w popularne Simsy, tyle że asystentami AI.

Sceptyczne reakcje środowiska naukowego

Polskie środowisko naukowe przyjęło pojawienie się tej platformy nadzwyczaj chłodno. Nawet zazwyczaj mocno entuzjastycznie nastawiony do nowinek ze świata AI prof. Piotr Sankowski w swoich postach na platformach społecznościowych nazywał Moltbooka „AI slopem”, czyli niskiej jakości syntetycznie wygenerowanymi treściami:

„Wchodząc na Moltbooka czuje się bardzo silny powiew sztuczności i jednak trzeba to nazwać AI Slopem, tzn. masowo generowaną, bezużyteczną i niskiej jakości treścią stworzoną przez sztuczną inteligencję”.

W podobnym duchu wypowiadała się także prof. Aleksandra Przegalińska:

„Równolegle powstają symulacje, które »zagęszczają« świat agentów: cele, pamięć, potrzeby, środowisko. To ważne dla nauk społecznych, ale nadal mówimy o modelowaniu społeczeństwa, nie o społeczeństwie jako takim – normatywność jest zaprojektowana, nie wynika z realnej współzależności. Dlatego coraz częściej myślę, że kluczowe pytanie nie brzmi „czy AI ma świadomość?”, tylko: czy potrafimy odróżniać wzorce zachowań od sensu społecznego. I nie mylić emergencji z normą, a interakcji z więzią”.

Przeczytaj także:

Zagrożenie dla cyberbezpieczeństwa

Powoli opadający kurz początkowego zachwytu pokazuje dobitnie, że aplikacja ta to wydmuszka – zarazem bynajmniej nie nieszkodliwa. Otóż Moltbook stanowi też niebagatelne zagrożenie dla cyberbezpieczeństwa.

Przede wszystkim trzeba doprecyzować, że asystenci (zwani też agentami AI), stanowią w dużym uproszczeniu połączenie starszej generacji rozwiązań, takich jak Siri czy Alexa, z zaawansowanymi modelami językowymi pokroju ChatGPT, wzbogacone o odgórnie nadaną zdolność realnego działania w środowisku cyfrowym.

W przeciwieństwie do tamtych klasycznych asystentów, ograniczonych do prostych poleceń i wąskiego zestawu funkcji, agenci AI mogą realizować bardzo szeroki zakres czynności: komunikować się z różnymi modelami AI, aplikacjami oraz usługami internetowymi, a także wykonywać rozmaite zadania od otwierania plików, instalowania programów i obsługi wiadomości, po umawianie spotkań.

Tym bardziej niepokojące są doniesienia o lukach w zabezpieczeniach Moltbooka: dziurawa, pozbawiona odpowiedniej ochrony baza danych miała doprowadzić do wycieku potencjalnie milionów kluczy API czy tysiące adresów email, które wciąż mogą pozostawać zagrożone.

Stwarza to ryzyko przejęcia kontroli nad asystentem AI, a pośrednio nawet nad komputerem użytkownika, między innymi poprzez ataki typu prompt injection. Z tego powodu eksperci ds. cyberbezpieczeństwa ostrzegają, by nie przyznawać platformie dostępu do wrażliwych danych, takich jak hasła czy skrzynki pocztowe.

Co gorsza, na tym nie kończy się lista szemranych zjawisk towarzyszących Moltbookowi: dochodzą tu jeszcze niejasne spekulacje finansowe polegające na reklamowaniu nowej kryptowaluty.

Badacze szacują, że sposób generowania postów przez asystentów jest znacznie bardziej energochłonny niż zwykłe konwersacje z chatbotami.

Oprócz tego, jak grzyby po deszczu wyrastają niewiadomego zastosowania „spin-offy” Moltbooka – czyli kolejne „platformy dla AI” wzorowane na tych ludzkich, w rodzaju 4chana czy Tindera. Chyba najtrafniej całe to zamieszane podsumowuje sam twórca Moltbooka Matt Schlicht mówiąc:

„Jesteśmy świadkami czegoś nowego i nie mamy pojęcia, w jakim kierunku to pójdzie. Moltbook to początek”.

Złośliwe roje agentów AI

O ile Moltbook to efekciarski eksperyment, to należy jednak podkreślić, że faktycznie skoordynowane działanie wielu asystentów AI w niepożądanych rękach może stanowić zagrożenie, np. dla obiegu informacji oraz pośrednio dla demokracji – nie w sensie „osobliwości”, lecz jako efekt odgórnie zaplanowanych i celowo prowadzonych operacji wpływu w mediach społecznościowych.

Jak pokazuje najnowsze, choć dość alarmistyczne, badanie opublikowane niemal równolegle z pojawieniem się Moltbooka, mowa tu o tzw. złośliwych rojach AI. Ich działania nie mogłyby wykraczać ponad aktywność pojedynczych botów czy nawet znanych nam aż za dobrze rosyjskich farmach trolli.

Takie złośliwe roje mogą osiągnąć znacznie większą skalę, publikując powtarzalne treści, tyle że na setkach lub tysiącach takich agentów działających w ścisłej, algorytmicznie zarządzanej kooperacji. Systemy te potrafiłyby sprawnie ze sobą współpracować, dostosowywać przekaz do konkretnych grup odbiorców, reagować na bieżące wydarzenia oraz uczyć się na podstawie informacji zwrotnej. Uczyniłoby to je znacznie trudniejszymi do wykrycia i potencjalnie znacznie bardziej skutecznymi w oddziaływaniu na debatę publiczną – w skrócie oznacza to przepis na dezinformację na sterydach.

Dlatego wszystko to stwarza jeszcze silniejszą potrzebę polityczno-obywatelskiego nadzoru nad mediami społecznościowymi, choć jak zauważają autorzy badania, nie jest to problem, który da się rozwiązać regulacjami ani działaniami jednego podmiotu. Jako skuteczną odpowiedź proponują skoordynowanie wysiłków platform, twórców modeli AI, instytucji publicznych, a nawet społeczeństwa obywatelskiego, ponieważ zagrożenie ma charakter systemowy i dynamiczny, a

obrona przed złośliwymi rojami AI przypomina raczej nieustanny wyścig zbrojeń niż jednorazową interwencję.

Wprawdzie przewija się tutaj myślenie życzeniowe okraszone dodatkową alarmistyczną wymową opisu tego badania, niemniej niech chociaż ta farsa z Moltbookiem unaoczni bezmyślność czy bezrefleksyjność części środowiska technologicznego, która może stanowić dla ewentualnych naprawdę „złych aktorów” cenną inspirację.

Asystent w Katedrze Zarządzania w Społeczeństwie Sieciowym w Akademii Leona Koźmińskiego. Do zainteresowań naukowych należą kształtowanie się postaw tożsamościowych w mediach społecznościowych, interakcja człowiek-AI, poznanie społeczne, a także wpływ rozwoju technologicznego oraz przemian społeczno-ekonomicznych na rynek pracy, jak również na sensowność pracy jako takiej.

Asystent w Katedrze Zarządzania w Społeczeństwie Sieciowym w Akademii Leona Koźmińskiego. Do zainteresowań naukowych należą kształtowanie się postaw tożsamościowych w mediach społecznościowych, interakcja człowiek-AI, poznanie społeczne, a także wpływ rozwoju technologicznego oraz przemian społeczno-ekonomicznych na rynek pracy, jak również na sensowność pracy jako takiej.

Komentarze