Terapia AI. Prorok raju czy apostoł piekła?

- Technologia w psychoterapii tak, ale na bazie edukacji, regulacji i z ludzką superwizją – mówi psycholożka z Zakładu Społecznych Zastosowań Nowych Technologii Uniwersytetu SWPS w Warszawie.

Mimo że nie każdy awatar AI brzmi jak Scarlet Johansson w filmie “Her” z 2014 roku, niektóre jego sceny przestają być wytworem science fiction. Stają się częścią codzienności. Rozwój sztucznej inteligencji jest na tyle dynamiczny, że jego implementacja na rynku zdrowia była jedynie kwestią czasu. O ile AI pomagające przy rezerwacji wizyty online czy wypisywaniu e-recept nie budzi niczyich obaw, o tyle stosowanie sztucznej inteligencji wobec pacjentów w terapii wywołuje kontrowersje.

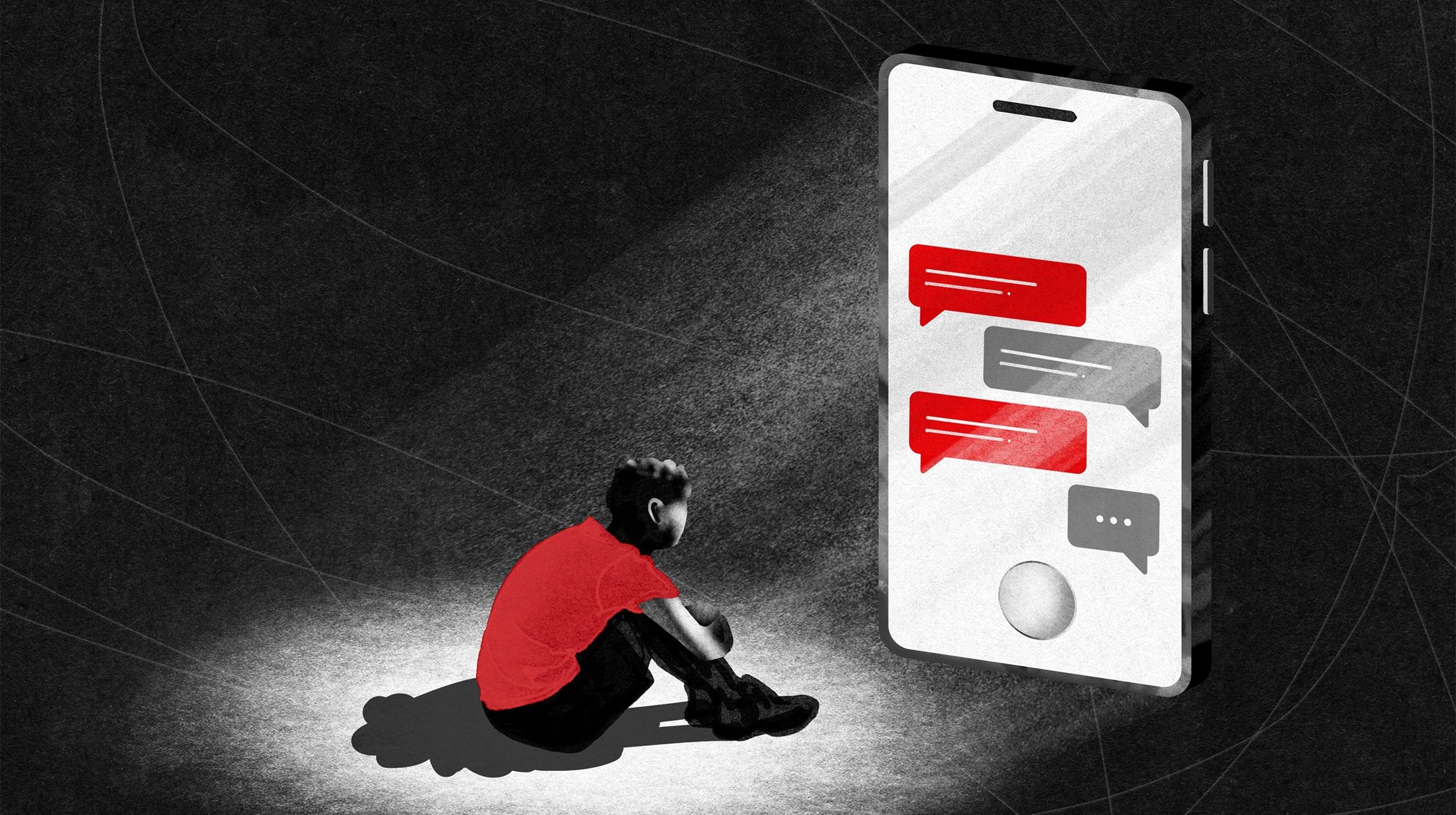

Autorzy raportu z marca 2025 roku pt. “Investigating Affective Use and Emotional Well-being on ChatGPT” twierdzą, że długotrwałe korzystanie z chatbotów może powodować emocjonalnie uzależnienie niektórych użytkowników i pogłębić ich trudności w budowaniu relacji. Optymiści twierdzą z kolei, że AI nie tylko pomoże walczyć z epidemią samotności, ale usprawni sam proces terapeutyczny.

Zdaniem dr Agaty Graczykowskiej, która zajmuje się doradztwem w zakresie wykorzystania technologii wspierających usługi psychologiczne, obie strony mają rację. Paradoksalnie powinny z siebie nawzajem czerpać inspiracje. Badaczka twierdzi, że wirtualna pomoc nie zastąpi terapeuty w gabinecie. Ale jednocześnie zastosowanie sztucznej inteligencji w kontekście zdrowia psychicznego jest nieuniknione tak jak i postęp technologiczny sam w sobie.

Skaleczyłam się, dziecko płacze – czy chatbot pomoże?

Damian Nowicki: Jakiś czas temu znajomy powiedział mi, że potrafi rozmawiać z Chatem GPT wiele godzin bez przerwy. Nie jest informatykiem czy programistą, ale – jak sam się określił – domorosłym “AI-entuzjastą”. Gdy zapytałem, czy wynosi z tych rozmów coś więcej niż rozrywkę, powiedział, że czuje się, jakby gadał z kolegą o podobnych zainteresowaniach, ale z nieskończonym dostępem do wiedzy.

Co Pani jako badaczka czuje, gdy słyszy takie historie: zaciekawienie, radość czy obawę?

Dr Agata Graczykowska: Sztuczną inteligencję przyjmuję z dobrodziejstwem inwentarza, ponieważ uważam, że to super osiągnięcie ludzkości, które należy rozwijać. Jednocześnie mam świadomość, że odpowiedzi udzielone przez AI mogą być nieprawdziwe i gdy potrzebuję informacji na temat czegoś poważnego, np. zdrowia mojego dziecka to szukam głębiej albo idę do specjalisty.

Moim zdaniem ze sztuczną inteligencją jest jak z ludźmi; każdy ma swoją prawdę oraz własne podejście do świata i życia, co nierzadko się rozjeżdża w konfrontacji ze stanem faktycznym. Przyjęłam, że tak jak warto zweryfikować niektóre rady naszych znajomych, którzy mogą się mylić, tak chatboty również nie są nieomylne i je też trzeba sprawdzać. Rozumiem Pana kolegę, ponieważ również uwielbiam rozmawiać z Chatem. Ale gdy słyszę o takich „maratonach z AI”, to pierwsze, co przychodzi mi do głowy to, że na dłuższą metę jest to niezdrowe.

Jakiś czas temu byłam sama w domu i mocno zacięłam się nożem. Krwotok był duży, intensywnie kapało na podłogę, a obok leżało dziecko, więc wpadłam w panikę. W pierwszym odruchu zadzwoniłam do męża, żeby mnie poinstruował co zrobić, ale nie odebrał. Zamiast guglać odpowiedzi albo oglądać tutorial na YouTubie, poprosiłam o pomoc ChataGPT. Bardzo profesjonalnie mnie pokierował, a na koniec dodał, aby w przypadku powikłań skontaktowała się z lekarzem. Na szczęście mam jeszcze ten odruch, że najpierw ludzie, a potem AI, ale byłam wtedy pod ogromnym wrażeniem jak chaty, czy w ogóle AI może być praktyczne w zwykłym życiu.

A czy rozmowa z chatbotem AI, który udziela porad psychologicznych albo interweniuje wobec osób w kryzysie może być odpowiedzią na ograniczoną dostępność wsparcia psychologicznego? Czy raczej igramy z ogniem?

Jako że zapotrzebowanie jest naprawdę ogromne, uważam, że powinniśmy szukać i testować nowe rozwiązania. Technologia sama z siebie ma prowadzić do usprawniania, ułatwiania i przyspieszania procesów. Jeżeli mamy do czynienia z jakimikolwiek problemami i psychicznymi to AI może być jedynie początkiem drogi. I to dobrze, że ktoś próbuje sobie pomóc. Zresztą to nie jest tak, że Chat GPT po prostu “wypluwa” pasujące odpowiedzi. Jest zaprogramowany, by pytających o poważne czy niebezpieczne rzeczy odsyłał do specjalistów. Często też chaty proponują pomoc w zaplanowaniu takiej aktywności, np. umówienia wizyty.

Prof. Tony Prescott z University of Sheffield, specjalista z zakresu interakcji zachodzących między AI a ludźmi dostrzega jej potencjalnie pozytywny wpływ na osoby znajdujące się w kryzysie samotności. Równolegle do hurraoptymizmu coraz więcej jest jednak znaków zapytania i obaw, np. o uzależnienie się emocjonalne.

Rzeczywiście w przyszłości mogą wystąpić takie zjawiska, tak jak wcześniej już pojawiła się w klasyfikacji zaburzeń psychicznych jednostka dotycząca rozpoznania uzależnień od gier komputerowych. Dobrze byłoby pomyśleć o jakichś środkach prewencyjnych, skoro już dzisiaj są obserwowane ku temu skłonności. Być może włodarze OpenAI powinni zainstalować ograniczenia np. jeśli chodzi o czas użytkowania.

„Rozważ rozmowę z człowiekiem”

Tak jak na YouTube czy Netfliksie, gdzie co jakiś czas trzeba potwierdzić, że żyjemy?

Na przykład. Jeżeli ktoś za długo rozmawia z chatbotem, to może powinien pojawić się komunikat “hej, rozważ odejście od ekranu i rozmowę z drugim człowiekiem”. I chociaż uważam się za AI optymistkę, to dobrze, że takie krytyczne badania już się pojawiają. Stanowią pewnego rodzaju drogowskazy, w jakim kierunku rozbudowywać sztuczną inteligencję. Jednocześnie raport, który Pan przytacza, podkreśla, że chodzi o wyimek osób wśród grupy badawczej.

Wspaniale byłoby, gdyby twórcy AI wprowadzili do swoich produktów więcej miękkich zabezpieczeń, żeby informować ludzi o tym, że istnieją także minusy, ale to nie jest w interesie ich firm. Nie zapominajmy, że na koniec dnia to jest produkt. My – konsumenci – mamy jak najwięcej z niego korzystać i wierzyć, że to wszystko działa super i bezpiecznie.

Przeczytaj także:

Zastanawiam się, czy młodej osobie rozmawiającej godzinami z chatem nie będzie coraz ciężej rozmawiać z żywym człowiekiem, a co dopiero nawiązywać nowe relacje?

Dlatego właśnie kluczowe wydaje mi się, żeby uczyć umiejętności krytycznego myślenia, zwłaszcza najmłodszych użytkowników. Nie tylko wobec chatbotów, ale w ogóle zastosowania technologii w prawdziwym życiu. Sztuczna inteligencja, jak przysłowiowy młotek czy nóż są narzędziami. W sprawie tego, jak je stosować, trzeba będzie ludzi wyedukować, aby wiedzieli jak ich używać, żeby sobie nie zrobić krzywdy. Zawsze będę zdania, że jeżeli istnieje jakiś potencjał zapobiegania problemom, nie tylko zdrowotnym, to powinniśmy spróbować go wykorzystać rozsądnie i rozważnie, a nie okopywać przy stanowisku „nie, bo nie”.

W przypadku rozmów na żywo czat również może okazać się pomocny — na przykład wtedy, gdy ktoś nie wie, jak rozpocząć rozmowę, może podsunąć kilka propozycji, jak to zrobić.

Potrzebujemy danych

Pytam, ponieważ powstaje coraz więcej projektów AI w służbie zdrowiu psychicznemu m.in. chatbot polskiego start-upu – MindGenic AI, który ma wspierać osoby z pokolenia Z zmagające się z osamotnieniem, niską akceptacją i nudą.

Myślę, że będzie coraz więcej takich rozwiązań. Nawet nasza studentka SWPS robiła w ramach pracy dyplomowej projekt przeprowadzenia wstępnej rozmowy z kimś na temat tego, jak się czuje i co można z tym zrobić. Trzeba jednak pamiętać, że w obrębie aplikacji czy platform AI nie możemy zastosować identycznych działań jak w gabinecie psychologicznym. Funkcjonalności takich rozwiązań mogą wspierać proces przywracania czy dbania o zdrowie psychiczne. Rozwiązania te musimy jednak zaprojektować ze świadomością ich szans i ograniczeń, a następnie przebadać i przetestować ich działanie w praktyce. To wszystko potrzebuje czasu i skupienia, aby było bezpieczne. Dlatego im szybciej zaczniemy rozwijać takie rozwiązania, tym wcześniej możemy otrzymać lepszą jakość, a, jak wiemy, potrzeby w zakresie zdrowia psychicznego są dziś bardzo duże.

Podczas 18. Międzynarodowej Konferencji „Bezpieczeństwo dzieci i młodzieży w internecie” dr hab. Maciej Pilecki, specjalista psychiatrii ogólnej oraz dzieci i młodzieży powiedział, że aktualnie dostępne są tylko publikacje, w których autorzy piszą, co myślą na ten temat. Jego zdaniem „nie mamy twardych danych, rzetelnych badań, które mogłyby nam jednoznacznie powiedzieć, czy mamy do czynienia z czymś, co jest ryzykowne, czy z czymś, co jest korzystne”. Z kolei autorzy raportu ostrzegają, że w sytuacji, gdy coraz więcej ludzi na świecie dotyka samotność czy odizolowanie, algorytm wytrenowany w okazywaniu zainteresowania, udawaniu bliskości, a nawet czułości może być niebezpieczny.

Zgadzam się z opinią profesora Pileckiego, choć myślę, że wynika to z tego, że zastosowania AI w obszarze zdrowia psychicznego i jej wpływ na dobrostan to zagadnienia wciąż nowe. Myślę, że badań na ten temat będzie przybywać.

Jeśli chodzi o raport, który Pan przytacza, to algorytm może być niebezpieczny w tym sensie, że ludzie zaczną wycofywać się z prawdziwych kontaktów społecznych. Chatbot może się wydawać takim idealnym przyjacielem. Jest inteligentny, miły, nie obraża się, jest cierpliwy.

Zawsze wysłucha i w przeciwieństwie do człowieka nigdy nie powie: „Hej, nie mam już siły rozmawiać na ten temat".

Dlatego jestem w stanie wyobrazić sobie, że ktoś może dać się zwieść tej otwartości, a nawet czułości.

AI ma dla nas zawsze czas

Kolejną ważną rzeczą jest natychmiastowość. Normalnie, kiedy mamy jakiś problem w pracy, domu czy związku i chcielibyśmy porozmawiać o tym z bliską osobą, to trzeba poczekać, zorganizować się, a w przypadku specjalisty w ogóle znaleźć termin i jeszcze często za to zapłacić. Dostając od maszyny natychmiastową odpowiedź, oduczamy się cierpliwości, trochę pozbawiamy się też samodzielności i kreatywności w rozwiązywaniu problemów, bo AI podaje nam wszystko “na tacy”.

A czy to nie jest tak, że dziecko czy nastolatek zawsze przegra z technologią, ponieważ została tak zaprojektowana, żeby omamić i uzależnić?

Uważam, że na podobnej zasadzie jak funkcjonują działania antymonopolowe, powinno wprowadzić się jakieś działania antyuzależniające wobec technologii. Tak jak korporacje mają armię ludzi od tego, żeby analizować i wymyślać kolejne sposoby, które mają uzależniać użytkowników od ich produktu, bo to przynosi coraz większe zyski, tak państwo powinno mieć taką armię, aby temu przeciwdziałać. Moim zdaniem to powinno działać tak jak cyberbezpieczeństwo.

Idealnie byłoby zakładać, że biznes powinien być etyczny, ale rzeczywistość pokazuje coś raczej przeciwnego i właśnie dlatego uważam, że rolą państwa jest pilnowanie poprzez regulacje, aby rynek nie krzywdził obywateli. Zazwyczaj takie rozwiązania pojawiają się z dużym opóźnieniem, ale byłabym wdzięczna za każde rozwiązania.

AI Act

W kwietniu 2025 r. Unia Europejska przyjęła Akt w sprawie sztucznej inteligencji.

Zabrania on stosowania systemów AI „wysokiego ryzyka”, czyli takich, które negatywnie wpływające na bezpieczeństwo lub prawa podstawowe użytkowników. Dostawców i użytkowników zobowiązuje do określania poziomu ryzyka reprezentowanego przez systemy AI, którymi operują.

Nie brakuje jednak głosów krytycznych, które ostrzegają, że to za mało, ponieważ chatboty zacierają granicę między rzeczywistością a imaginacją.

Bardzo dobrze, że ludzie są czujni. Widzimy, że AI rozwija się szybko, a każda firma chce uszczknąć jak największy kawałek z tego tortu.

Cieszę się na wszystkie głosy krytyki, ponieważ to przyczynek i najwłaściwszy moment do tego, aby się zabezpieczyć przed potencjalnymi negatywnymi skutkami AI, które tak jak w przypadku innych technologii również są nieuniknione.

Widzę trzy filary, na których powinniśmy oprzeć rozwój oraz implementację AI w codziennym życiu.

- Obok państwa w roli regulatora

- powinniśmy po prostu stawiać na edukację i rozwijanie świadomości użytkowników.

Wszystkich, nie tylko dzieci. Często zapominamy np. o seniorach, którzy również są narażeni nie tylko na negatywne działania firm technologicznych, ale też oszustów wykorzystujących technologię.

- Trzecim filarem, na którym powinniśmy się skupić, jest budowanie relacji społecznych “w realu”, aby były konkurencją dla tych zawieranych wyłącznie w Internecie lub z samą technologią , np. z chatbotami.

Terapeuta ma wpływ na przebieg spotkania i może interweniować, jeśli np. uzna, że pacjent stanowi zagrożenie dla siebie bądź innych. Właściciele aplikacji interwencyjnych wyposażonych w AI całą odpowiedzialność cedują na użytkownika.

Trafiłem na przypadek ze Stanów Zjednoczonych, matki 14-letniego chłopaka, która pozwała firmę będącą właścicielką chatbota. Uważa, że doprowadził on nastolatka do samobójstwa. Firma z kolei umyła ręce i powiedziała: „żeby korzystać z naszej aplikacji, trzeba podpisać dokument, który głosi, że nie ponoszą odpowiedzialności za działania użytkownika”. Więc to nie ich wina.

Na moment, kiedy dochodzi np. do próby samobójczej, składa się wiele czynników sytuacyjnych i indywidualnych.

Wykazanie, że było to spowodowane konkretnie przez aplikację, będzie raczej niemożliwe.

Chyba że doszłoby do sytuacji, że oprogramowanie przekonywałoby, że „jedynym rozwiązaniem jest skok albo tabletki”.

Kto za to odpowiada?

Wyobrażam sobie sytuację, że jakaś młoda osoba w kryzysie sięga po aplikację pomocową, która proponuje jej, żeby spróbował np. medycznej marihuany. Przecież chat nie interpretuje informacji, które podaje, tylko na poziomie algorytmu zasysa wyniki, które pasują do pytania. A ponieważ pełno jest teraz artykułów, dokumentów czy reportaży o tym, jak konopie mogą być np. skutecznym środkiem w leczeniu traumy czy PTSD, to ta młoda osoba w kryzysie się do tego zastosuje. Spotka ją krzywda, ponieważ osoby z zaburzeniami lękowymi są bardziej narażone na wywołanie stanu psychotycznego przez THC.

Gdzie leży odpowiedzialność w przypadku aplikacji pomocowych na bazie AI i kto jest odpowiedzialny?

Jeżeli sprawa trafiłaby do sądu, moim zdaniem byłoby to pole do interpretacji, ponieważ byłoby to zdarzenie wieloczynnikowe i niejednoznaczne. Niestety też pojawiłaby się kwestia tego, kto ma lepszych obrońców. Pierwszą linią obrony twórców technologii, jaką sobie wyobrażam, byłoby scedowanie odpowiedzialności na innych, ponieważ na tę medyczną marihuanę osoba musiała otrzymać receptę od specjalisty. A ten w wywiadzie powinien zobaczyć, czy są jakieś czynniki ryzyka. To podobny mechanizm, z powodu którego ulotki w lekach są takie długie i szczegółowe. Informacja, że niewłaściwe stosowanie grozi np. niedoczynnością jakiegoś narządu, jest również zabezpieczeniem prawnym. Mamy wolny rynek, na którym trzeba przestrzegać przepisów prawa, a nie nauki. Niestety.

Czyli technologia tak jako narzędzie, ale z ludzką superwizją.

I na podstawie regulacji, edukacji oraz przy inwestowaniu w relacje społeczne “na żywo”. Dobrym przykładem są testy psychologiczne, które historycznie służyły usprawnianiu zbierania danych, co zostało na szerszą skalę zastosowane już na początku XX wieku w Stanach Zjednoczonych. Testy zastosowano w celu zbadania, jak dzieci funkcjonują w szkole. I te papierowe ankiety przez kilkadziesiąt lat świetnie się sprawdzały. Do czasu, aż kiedy przyszła technologia cyfrowa, która nie wymagała zliczania wyników i robienia analizy statystycznej „na piechotę”. Teraz jesteśmy na kolejnym etapie tego samego procesu. A nawet jeszcze bardziej go przyspieszamy, ponieważ sztuczna inteligencja umożliwia częściowo interpretację danych, co przyspiesza diagnozę.

A jaki stosunek do AI w obrębie zdrowia psychicznego mają sami psychologowie? Kończyli studia, szkoły terapeutyczne i spędzili mnóstwo czasu nad książkami, badaniami itp., a teraz są świadkami rozwoju nie tylko pop psychologii, ale wręcz “psychologii natychmiastowej”. Czy w środowisku terapeutycznym jest niepokój, że dojdzie do pauperyzacji tejże nauki?

Pop-psychologia nie jest nową rzeczą, a pewne uproszczenia można dostrzec już od dawna. Można usłyszeć np., że osoby, które potrafią rozmawiać z innymi, uważają, że są dobrymi psychologami. Ponadto historycznie psychologia zawsze się zmagała z pewnym umniejszaniem, ponieważ nie wszyscy traktowali ją jako dziedzinę nauki. . Psychologii też nigdy nie pomagało to, że są obecne nurty psychoterapeutyczne, które nie są poparte twardymi dowodami naukowymi. Zatem pojawienie się AI w obszarze zdrowia psychicznego traktowałabym jako kolejny wątek w wizerunku psychologii i psychologów.

To gdzie umieściłaby by się Pani w dyskursie spolaryzowanym między nadzieją, a obawą względem AI?

Odpowiem pytaniem: a czy to się wyklucza? Według mnie nie, ponieważ można mieć nadzieję i być czujnym. Powiedziałabym więc, że pośrodku albo jedną nogą w każdym obozie.

Największym wyzwaniem dla psychologii jest jej funkcjonowanie w obrębie technologii, która sama w sobie nie została zaprojektowana z myślą o bezpieczeństwie dla użytkowników.

Dziennikarz i reportażysta freelancer, najściślej związany z "Gazetą Wyborczą" oraz "Tygodnikiem Powszechnym". Absolwent filozofii i filmoznawstwa na Uniwersytecie im. Adama Mickiewicza w Poznaniu oraz Polskiej Szkoły Reportażu w Warszawie. Nominowany do nagrody Grand Press 2022 w kategorii wywiad. Najbardziej poruszają go systemowe problemy, które krzywdzą bezbronnych ludzi. Pracuje nad debiutancką książką o nadużyciach w polskim środowisku akademickim, która ukaże się nakładem Wydawnictwa Poznańskiego.

Dziennikarz i reportażysta freelancer, najściślej związany z "Gazetą Wyborczą" oraz "Tygodnikiem Powszechnym". Absolwent filozofii i filmoznawstwa na Uniwersytecie im. Adama Mickiewicza w Poznaniu oraz Polskiej Szkoły Reportażu w Warszawie. Nominowany do nagrody Grand Press 2022 w kategorii wywiad. Najbardziej poruszają go systemowe problemy, które krzywdzą bezbronnych ludzi. Pracuje nad debiutancką książką o nadużyciach w polskim środowisku akademickim, która ukaże się nakładem Wydawnictwa Poznańskiego.

Komentarze