Polska musi się przygotować. Postęp AI umożliwia celowane ataki PsyOps na ogromną skalę

Imponujący rozwój dużych modeli językowych oraz innych modeli generatywnych wzbudza na przemian ekscytację i niepokój. Najchętniej dyskutowane obawy – np. o przyszłość wielu zawodów – mogą przysłonić o wiele bliższe i w krótkim okresie bardziej prawdopodobne zagrożenie

Powiedz nam, co myślisz o OKO.press! Weź udział w krótkiej, anonimowej ankiecie.

Przejdź do ankietyW połowie maja OpenAI ogłosiło nową wersję swojego flagowego modelu generatywnego, ChatGPT4.o. Odbiło się to szerokim echem jako technologiczna ciekawostka i zwiastun nachodzącej robo-apokalipsy. Zaraz potem kontratakował Google ze swoim Gemini, pogłębiając tylko powszechną fascynację tą pierwszą generacją prawdziwie wielomodalnych wielkich modeli transformatorowych.

Jedno i drugie miało być momentem przełomowym, w którym znaleźliśmy w końcu praktyczne zastosowanie dla tej imponującej, ale dość bezwładnej jak dotąd technologii. Nabawiliśmy się również już chyba na dobre kryzysu egzystencjalnego, stając naprzeciw rozpędzającej się fali sztucznej inteligencji.

Panika szerzy się w każdym sektorze gospodarki, a na pewno na rynkach usług niewymagających pracy fizycznej. Spółki w popłochu zaczęły dopisywać „AI” do swoich nazw, żeby zwabić szukających szybkiego zysku inwestorów, zupełnie tak jak parę lat temu robiły to z blockchainem.

Poważne media zupełnie serio roztrząsają, jak dalece wytrenowane na krzemie macierze są podobne do dzieci. Wydaje się, że goręcej w tej sprawie już być nie może – przynajmniej, dopóki nie zobaczymy robotów Boston Dynamics porozstawianych w Biedronkach zamiast pracowników ochrony.

Przeczytaj także:

Gospodarcza rewolucja nie wydarzy się z dnia na dzień

A jednak jest jeszcze nie dość gorąco. Wśród powszechnych obaw o utratę środków do życia i wobec kolejnego ciosu dla ludzkiego poczucia wyjątkowości, ekonomia i futurologia dostały pierwszeństwo w interpretowaniu znaczenia i roli tej nowej technologii.

Z niezwykłą regularnością pojawia się przygotowywane przez różne instytucje raporty informujące o stale rosnącej liczbie pracowników obawiających się zastąpienia przez AI (jak ostatnio Work Trend Index 2024 prowadzony przez Microsoft i LinkedIn).

Zaraz po publikacji nadchodzi z kolei wypowiedź jakiegoś CEO, profesora lub eksperta przekonujących, że to nie AI jest zagrożeniem, tylko powstrzymywanie się od jego wykorzystania (jak np. na konferencji Salesforce’a w Singapurze ostrzegał kilka dni temu dyrektor ds. innowacji AI Singapore), bo dopiero opór czyni kogoś niekonkurencyjnym.

Niemal cała publiczna dyskusja o sztucznej inteligencji została sprowadzona do problemu zatrudnienia i zastępowalności ludzi w prywatnych organizacjach for-profit.

Jakkolwiek przerażająca jest perspektywa utraty dochodu na rzecz firmy z USA, która za półdarmo i bez żadnych zabezpieczeń wytrenowała model twojego zawodu na wytworzonych przez ciebie danych, nawet najwięksi pesymiści nie spodziewają się tych przepowiadanych masowych zwolnień w kolejnym miesiącu, ani nawet w kolejnym roku.

Nawet gdyby niektóre wielkie firmy życzyłyby sobie inaczej, wciąż istnieje w Europie prawo pracy, które spowalnia i łagodzi takie wielkie przemiany, by minimalizować ludzkie cierpienie.

Stworzenie gospodarki opartej o internet zajęło około dwudziestu lat. Przestawienie się na gospodarkę opartą o sztuczną inteligencję też nie wydarzy się z dnia na dzień. Mamy czas, by się do tej przemiany przygotować, zarówno w rodzinach, jak i w społeczeństwie. Za najlepszy dowód niech posłuży to, ile czasu antenowego poświęcamy obecnie tym dywagacjom.

Tymczasem istnieje przynajmniej jedna dziedzina dotknięta bezpośrednio przez rewelacje ostatnich tygodni, która wymaga natychmiastowej reakcji – na skali mierzonej w dniach, nie w miesiącach.

Rok wyborów w cieniu wielkich technologii

Cofnijmy się na chwilę do roku 2016. NASA po raz pierwszy ogłosiła, że poprzedni rok był najgorętszy w mierzalnej historii Ziemi. Lato przeszło pod znakiem Euro2016 we Francji, które wygrała Portugalia, ale Chorwaci też dali Słowianom coś do świętowania.

Pentagon przekonywał, że po aneksji Krymu Rosja nie ma już żadnych planów wobec Ukrainy. W kinach rządziła Amy Adams w „Nowym początku” i „Zwierzętach nocy”.

W 2016 wszyscy usłyszeli też o firmie badawczej Cambridge Analytica, która wykorzystała profile 50 milionów użytkowników Facebooka do utworzenia sylwetek amerykańskich wyborców, wpływając na wynik listopadowych wyborów prezydenckich w USA. Ta sama spółka miała ścisłe powiązania personalne ze Stevenem Bannonem (redaktorem naczelnym niesławnego Breitbart News), który był jej wiceprezesem. A także z organizatorami orędującej za brexitem brytyjskiej kampanii Leave.EU, której na wczesnych etapach Cambridge Analytica oficjalnie doradzała.

Dane o historii aktywności użytkowników zebrane na jednym portalu społecznościowym wykorzystane przez jedną spółkę wystarczyły wówczas, by na wiele lat namieszać po obu stronach Atlantyku.

Trudno nie dostrzec podobieństw między rokiem 2016 i 2024. Rosyjska inwazja na Ukrainę wchodzi w nową, wyjątkowo krwawą fazę. Konflikt Hamasu z Izraelem znów pustoszy Bliski Wschód.

Jest to rok wyborów do władz federalnych w USA, do Izby Gmin w Wielkiej Brytanii (przed styczniem 2025), do Parlamentu Europejskiego już za trzy tygodnie, a na przestrzeni całego roku odbędą się również wybory na poziomie centralnym w Austrii, Belgii, Portugalii, Słowacji, Litwie, Chorwacji, Mołdowie, Gruzji i Rumunii.

Tak jak przed ośmioma laty, wszystkie te decyzje trzeba podejmować w cieniu wielkiej technologii. Ale tym razem zamiast danych z jednego portalu wykorzystanych przez jedną spółkę konsultingową, cały świat dostał nieograniczony dostęp do fazy testowej najpotężniejszych narzędzi komunikacyjnych od czasu powstania mediów społecznościowych, a może i internetu.

Human hacking coraz łatwiejszy

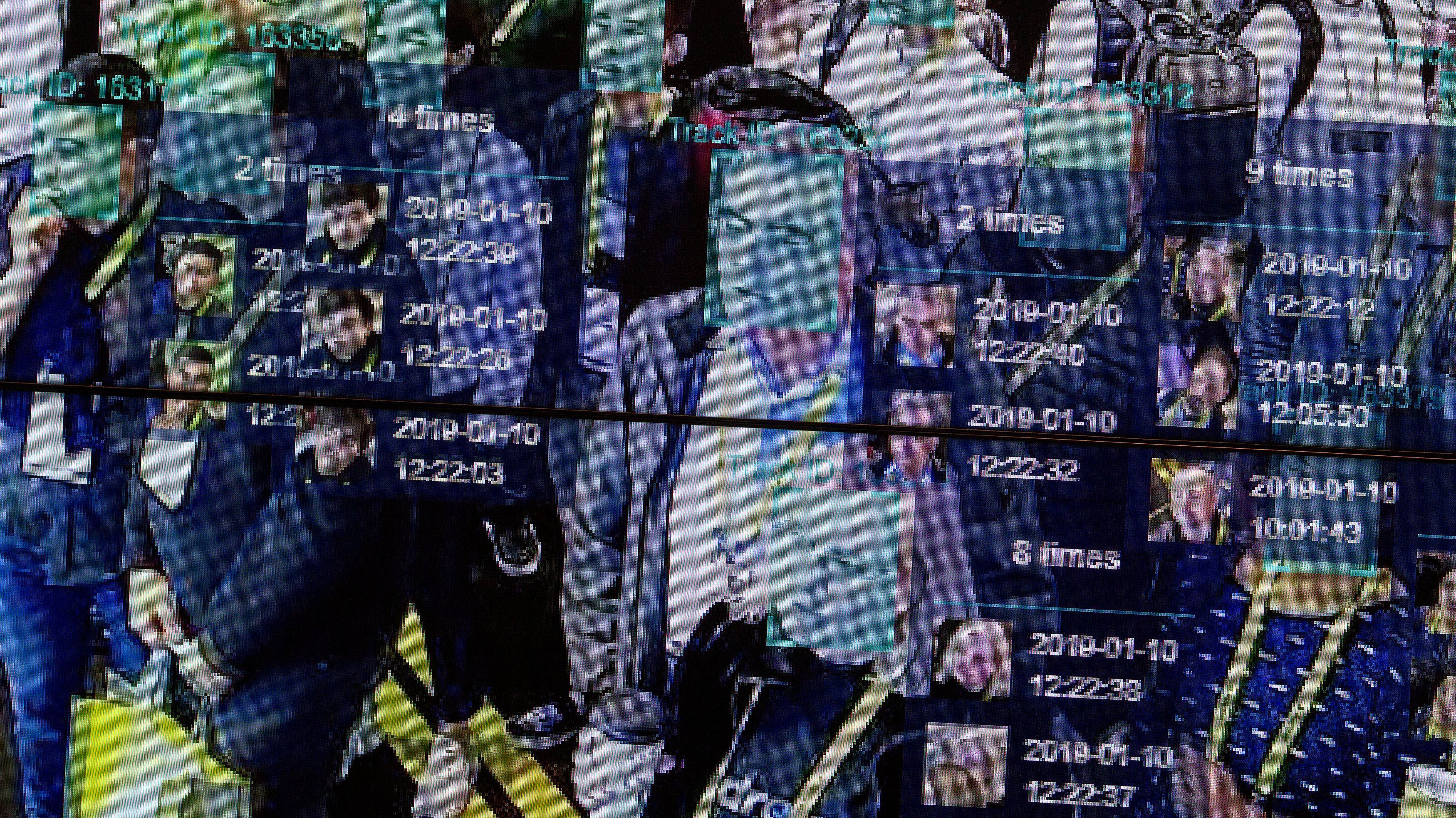

W porównaniu do wielomodalnych modeli językowych, narzędzia wykorzystane w 2016 roku przez Cambridge Analytica przypominają zajmujący cały piętro mainframe przy nowym MacBooku. Przepaść w skali możliwych zastosowań w konfliktach między państwami jest taka jak między ulotkami zrzucanymi z samolotów przez amerykańską armię w czasie wojny w Wietnamie a wypuszczanymi przez Rosjan deepfake’ami z prezydentem Zełenskim wzywającym Ukraińców do złożenia broni.

Za niewygórowaną cenę tokenów i subskrypcji platformy obliczeniowej Azure można teraz przeprowadzać indywidualnie profilowane operacje psychologiczne (PSYOP) na niewyobrażalną wcześniej skalę.

Zagrożenie płynące ze strony powszechnie dostępnych modeli generatywnych nie polega na ich inteligencji. Zamiast tego powinniśmy się martwić, że nieprzychylni nam aktorzy mogą z rosnąco wykładniczo łatwością stosować je do tzw. human hackingu, czyli wykorzystywania ludzkich słabości do unieszkodliwienia lub uzyskania dostępu do kluczowej infrastruktury. Czy jesteśmy na to gotowi?

Scenariusz 1.

Suwałki, godzina szósta rano. Dzwoni nieznany lub zastrzeżony numer. Ratownik medyczny pyta, czy nazywasz się Kowalska, a ty odpowiadasz, że owszem. Twoi rodzice ulegli strasznemu wypadkowi, w ich dom wjechała ciężarówka. A może babcia miała wylew. Ratownik podaje jej imię i numer PESEL. Proszę natychmiast przyjechać do szpitala.

W pośpiechu się ubierasz i wyjeżdżasz na główną ulicę, a tam korek. Trzydzieści tysięcy samochodów wyjechało w tym samym czasie i zablokowało wszystkie ulice w promieniu półtora kilometra od największego szpitala w okolicy i posterunku straży pożarnej. W przypadku fizycznego ataku karetki i wozy strażackie nie mają, jak wyjechać.

Scenariusz 2.

Lublin, zaraz po pracy. Po powrocie do domu oglądasz serial i przeglądasz wiadomości od rodziny. Wśród powiadomień widzisz wiadomość na Telegramie pochodzącą z konta twojego urzędu miejskiego, a może Rządowego Centrum Bezpieczeństwa. Ostrzegają przed bardzo silnymi wiatrami i nagłymi ulewami w całym województwie.

Nie zwracasz na to uwagi, ciągle takie przychodzą. Ale po godzinie pojawia się kolejna: wiatry zrywają dachy i powalają drzewa przy drogach, zostań w domu. W porządku i tak nie miałeś innych planów. W środku nocy przychodzi jeszcze jedna: sytuacja bez zmian, możliwe przerwy w dostawie prądu i zakłócenia dostaw paliwa i żywności. Przygotuj się, jak możesz. Odpowiadasz w komunikatorze z pytaniem o to, czy twój kod pocztowy jest bezpośrednio zagrożony.

Wtedy dzwoni do ciebie urzędnik i mówi zaniepokojony, że ul. Turystyczna w stronę obwodnicy będzie w samym epicentrum i żebyś się spieszył. Przesyła też mapkę, którą dostał z centrum zarządzania kryzysowego z zaznaczoną na czerwono strefą dokładnie wokół twojego domu. Lekko spanikowany wyjeżdżasz wcześniej, żeby przed pracą zatankować do pełna, i może kupić więcej chleba. W mieście kolejki. Na większości stacji zabrakło już 95, a przy dystrybutorze ktoś się kłóci o to, ile 98 każdy może wlewać. Kierowcy w dieslach odbijają się wkurzeni od kolejnej pustej cysterny.

Scenariusz 3.

W powiecie olkuskim trwa lokalne referendum w sprawie umiejscowienia nowego centrum logistycznego i fabryki podzespołów elektronicznych. Frekwencja będzie bardzo blisko wymaganych 30 proc., by głosowanie było wiążące. Na WhatsAppie dzwoni do ciebie mama i pyta, czy słyszałaś o wybuchu na poczcie przy ul. Osieckiej. Prosi cię, żebyś została w domu, bo wygląda to podejrzanie. „Daj spokój, mamo, to pewnie tylko gaz”.

Piszesz do koleżanki z siłowni, że twoi rodzice wszędzie widzą terrorystów. Od razu odpisuje, znacznie szybciej niż zazwyczaj. Jej brat wysłał jej przed chwilą zrzut ekranu z nagłówkiem artykułu o wybuchu w Stokrotce przy Krasińskiego. Podobno byli ranni. Decydujecie się zostać, tak na wszelki wypadek. Podobnie postanowiło siedem tysięcy mieszkańców Olkusza. Frekwencja wyniosła 28 proc. Decyzja o budowie fabryki odsuwa się o kolejnych sześć miesięcy.

Zupełnie nowy rodzaj zagrożenia

Powyższe scenariusze mogą wydawać się nieprawdopodobne, ale wszystkie da się zrealizować już teraz przy pomocy modeli takich jak GPT4.o. Poranny telefon, gdy brakuje nam czujności, naturalnie brzmiący głos mężczyzny podającego się za ratownika, porównywanie numeru telefonu z bazą PESEL klientów firmy budowlanej kupionej od handlarza danymi, to wszystko dzieje się już teraz.

Phishing, vishing, smishing, spear phishing, pretexting; te wszystkie formy oszustw przez środki komunikacji zdalnej są z nami już od dawna. Jednak do tej pory do ich realizacji potrzebni byli ludzie. Oznaczało to, że przeprowadzenie indywidualnie celowanej operacji psychologicznej na skalę, która mogłaby wpłynąć na mieszkańców wystarczająco dużego obszaru obcego państwa, było poza zasięgiem nawet najlepiej finansowanych agencji rządowych na świecie.

Wielomodalne modele generatywne właśnie to zmieniły. Generowanie dziesiątek czy setek tysięcy wzajemnie wspierających się fragmentów tekstu, obrazów i dźwięku, zarówno z wyprzedzeniem, jak i na potrzeby odpowiedzi w czasie rzeczywistym, stało się trywialne.

Powiązanie tych modeli z kupionymi lub kradzionymi bazami danych osobowych przy pomocy procedury nazywanej RAG (Retrieval Augmented Generation, generowanie na podstawie wyszukania) też jest w zasięgu ręki.

Boty na Twitterze, farmy internetowych trolli, a nawet pojedyncze deepfake’i to igraszka przy zautomatyzowanej armii internetowych oszustów znających twoją serię i numer dowodu, lokalizację, konta w mediach społecznościowych i numer telefonu. Mogą poświęcić ci dowolnie dużo czasu, odpowiadać rzeczowo na twoje pytania i są w stanie wygenerować artykuł prasowy lub zrzut ekranu z otwartej na Facebooku przeglądarki potwierdzający wszystko, co mówią w ciągu kilku sekund.

Wysokie tempo i łatwość generowania precyzyjnie dobranych i świetnie poinformowanych wirtualnych agentów zdolnych do utrzymania konwersacji i fabrykowania dowodów uprawdopodabniających oszustwo w trakcie rozmowy stanowi zupełnie nowy rodzaj zagrożenia na polu wojny informacyjnej. Dlatego obrona przed nim też wymaga nowego podejścia.

Państwo musi się przygotować

Potrzebujemy w Polsce, a tak naprawdę w każdym kraju Unii Europejskiej, grupy szybkiego reagowania, która byłaby w stanie wykrywać takie próby w czasie rzeczywistym.

Czołowa unijna jednostka do spraw przeciwdziałania obcym operacjom informacyjnym, EU StratCom Task Force East, zbiera dane i raportuje w cyklu cotygodniowym. Między innymi publikując biuletyn „Disinformation Review”. Od 13 maja 2024 taka prędkość jest już nieakceptowalna.

W dobie wielomodalnych modeli generatywnych musimy traktować przestrzeń informacyjną na równi z systemami telekomunikacyjnymi czy przestrzenią powietrzną. Skuteczny atak można teraz będzie przeprowadzić nawet w kilka godzin, co wymusza monitorowanie w trybie ciągłym.

Ze względu na szeroką naturę problemu, instytucja odpowiedzialna za monitorowanie przestrzeni informacyjnej musi obejmować wiele dyscyplin. Aby być skuteczna, jej zespoły powinny zatrudniać

- lingwistów,

- psychologów,

- analityków medialnych,

- dziennikarzy,

- specjalistów od przetwarzania języka naturalnego,

- analizy obrazu i uczenia maszynowego,

- a nawet wojskowych i przedstawicieli instytucji publicznych zorientowanych w rozmieszczeniu i funkcjonowaniu infrastruktury istotnej z punktu widzenia obronności państwa.

Zatem w praktyce, takie biuro pełniłoby również funkcję łącznika i koordynatora współpracy między resortami w zakresie ochrony polskiej i europejskiej przestrzeni informacyjnej.

Jego główne zadania obejmowałyby zatem:

- Bieżące monitorowanie przestrzeni informacyjnej obejmującej: media społecznościowe, nowe strony indeksowane przez wyszukiwarki internetowe, ogólne natężenie ruchu w tematycznie zdefiniowanych obszarach polskiego internetu. Ale także średnią i chwilową ekspozycję na możliwie zagrażające bezpieczeństwu państwa indywidualnie celowane i niecelowane próby human hackingu i manipulacji online (np. przez utrzymywanie siatki kont w mediach społecznościowych i pomiar częstotliwości i zakresu prób nawiązania kontaktu przez nieznane konta).

- Przyjmowanie zapytań i weryfikacja zgłoszeń od instytucji publicznych, agencji rządowych, sądów, służb mundurowych i mediów krajowych pod kątem sprawdzania technicznych i treściowych właściwości materiałów audio-wideo wskazujących na ich generatywne pochodzenie.

- Wydawanie popartych dowodami bezpośrednich i pośrednich (np. poprzez informację do mediów krajowych) publicznych ostrzeżeń w sprawie formy, rodzaju, spodziewanego celu i tematyki nasilających się aktualnie operacji psychologicznych i informacyjnych.

- Modelowanie i testowanie odporności połączonych systemów informacyjnych oraz kluczowej infrastruktury na zdecentralizowane ataki PsyOp.

- Współpraca z instytucjami europejskimi przy ich wykrywaniu.

Część tych ról spełniają już należące do różnych instytucji zespoły reagowania na incydenty bezpieczeństwa komputerowego (CSIRT) – np. CSIRT ABW, CSIRT KNF, CSIRT NASK. Nowy poziom zagrożeń wymaga jednak koordynacji oraz wykorzystania pełnego wachlarza metod w wielu dziedzinach życia społecznego.

Imponujący rozwój dużych modeli językowych oraz innych modeli generatywnych w ciągu ostatnich miesięcy wzbudza na przemian ekscytację i niepokój.

Wśród obaw o środki do życia, spotęgowanych przez nowe narzędzia obliczeniowe dostępne na rynku, możemy przegapić bardzo przyziemne, lecz o wiele bliższe i w krótkim okresie bardziej prawdopodobne zagrożenie o równie nieprzewidywalnych skutkach.

Jednak, jeżeli nasza odpowiedź przyjdzie w porę i z pełnym zaangażowaniem, dużą część tego wiszącego nad nami niebezpieczeństwa powinno udać się unieszkodliwić.

Gospodarka

Policja i służby

Ministerstwo Cyfryzacji

Ministerstwo Obrony Narodowej

ChatGPT

sztuczna inteligencja

Specjalista ds. bezpieczeństwa informacyjnego i informatyki społecznej. Wykładowca w Akademii Leona Koźmińskiego (Management in Digital and Networked Societies). Dla sektora prywatnego prowadzi zespoły badawczo-rozwojowe w zakresie przetwarzania języka, analizy sieciowej i AI-resilience. Szkoli przedsiębiorców i urzędników. Wcześniej GSR na Uniwersytecie Kalifornijskim, Los Angeles (UCLA) (Emergence of Communication Lab, CoMind Lab), visiting fellow na Uniwersytecie Harvarda, asystent badawczy na Uniwersytecie Yale, EIT Food Research Fellow, dziennikarz i programista. Studiował na UCLA, w Kolegium Europejskim (Natolin), Uniwersytecie Środkowoeuropejskim w Budapeszcie (CEU) oraz na Uniwersytecie Warszawskim (Human Interactivity and Language Lab).

Specjalista ds. bezpieczeństwa informacyjnego i informatyki społecznej. Wykładowca w Akademii Leona Koźmińskiego (Management in Digital and Networked Societies). Dla sektora prywatnego prowadzi zespoły badawczo-rozwojowe w zakresie przetwarzania języka, analizy sieciowej i AI-resilience. Szkoli przedsiębiorców i urzędników. Wcześniej GSR na Uniwersytecie Kalifornijskim, Los Angeles (UCLA) (Emergence of Communication Lab, CoMind Lab), visiting fellow na Uniwersytecie Harvarda, asystent badawczy na Uniwersytecie Yale, EIT Food Research Fellow, dziennikarz i programista. Studiował na UCLA, w Kolegium Europejskim (Natolin), Uniwersytecie Środkowoeuropejskim w Budapeszcie (CEU) oraz na Uniwersytecie Warszawskim (Human Interactivity and Language Lab).

Komentarze